Studio Now

Aufbruch Award | Wir bieten eine zeitgemäße Bühne für digitale Wegbereiter

Virtual Production

Intro

Wie werden herausragende Leistungen inspirierender Persönlichkeiten gewürdigt, wenn man sie nicht auf einer großen Bühne ins Rampenlicht bringen darf?

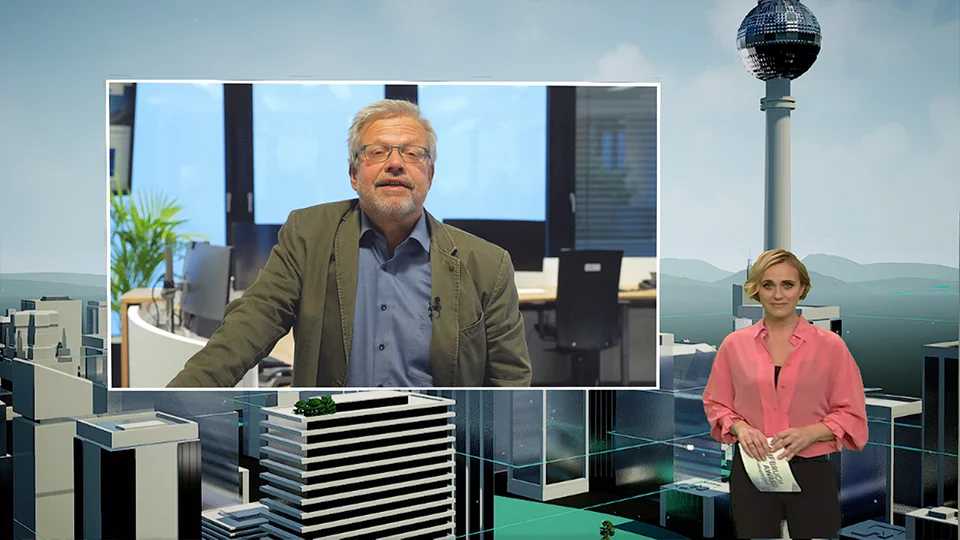

In Zeiten von Corona und Lockdowns war dies eine Herausforderung, die wir gemeinsam mit einem ebenso motivierten Team zu meistern hatten. In drei Kategorien wurden die Gewinner*innen und deren Projekte in einer jeweils eigens dafür entworfenen XR- Umgebung live aus einem Greenscreen Studio heraus ins Internet übertragen. Moderiert wurde die Preisverleihung von Caren Miosga, die die Auszeichnungen aus den Bereichen Bildung, Gesellschaft und Wirtschaft auf Initiative der Süddeutschen Zeitung und Google hin virtuell überreichte.

Award

Der Award für digitale Wegbereiter

Der Aufbruch Award ehrt Menschen mit Mut, Ideen und Tatendrang, die mit ihren Projekten in unterschiedlichen Bereichen der Digitalisierung im Zeitalter des digitalen Wandels eine Vorreiterrolle einnehmen.

Er fand erstmals am 15. November 2020, dem Vorabend des SZ-Wirtschaftsgipfels als feierliche online Preisverleihung statt.

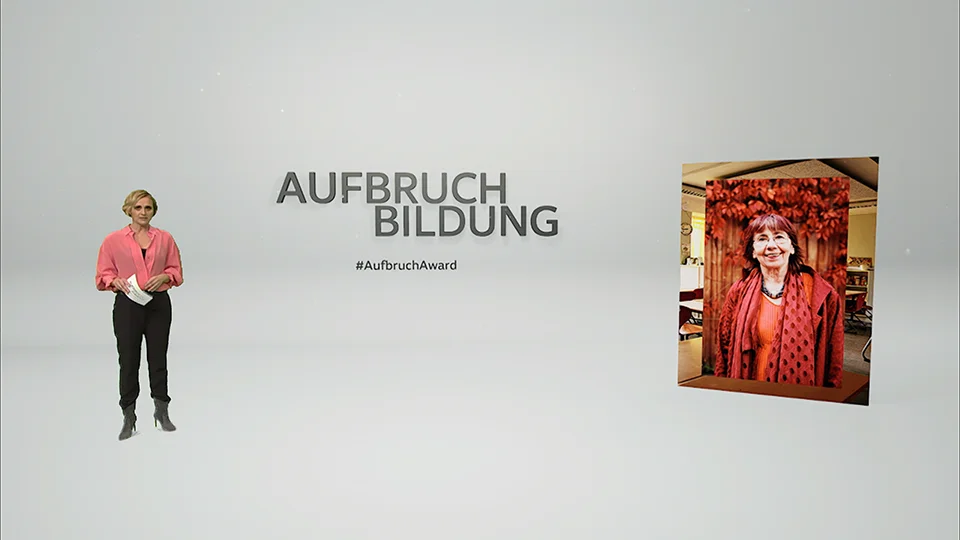

Die dreiköpfige Jury entschied sich in diesem Jahr in den Kategorien Gesellschaft, Wirtschaft und Bildung, für die Projekte der Sieger Christina Lang, Nico Rosberg und Margret Rasfeld.

Auftrag

Eine Moderatorin geht auf Tour – Die virtuelle Reise in die Ideenwelten der Preisträger*innen

Wir wurden mit der Aufgabe betraut, ein Set an animierten XR-Environments zu entwickeln in denen zum einen die Moderatorin Caren Miosga die Preisträger ankündigen und ehren durfte und zum anderen die Zuschauer mit in die jeweilige Schaffensbereiche der Sieger eintauchen können.

Dabei sollte es die Möglichkeit geben die Gewinner via eingebetteten Video-Call Kacheln zu interviewen. Zudem sollten auch jeweils Laudatoren und die Juroren, die über Videobild live zugeschaltet werden können, zu Wort kommen.

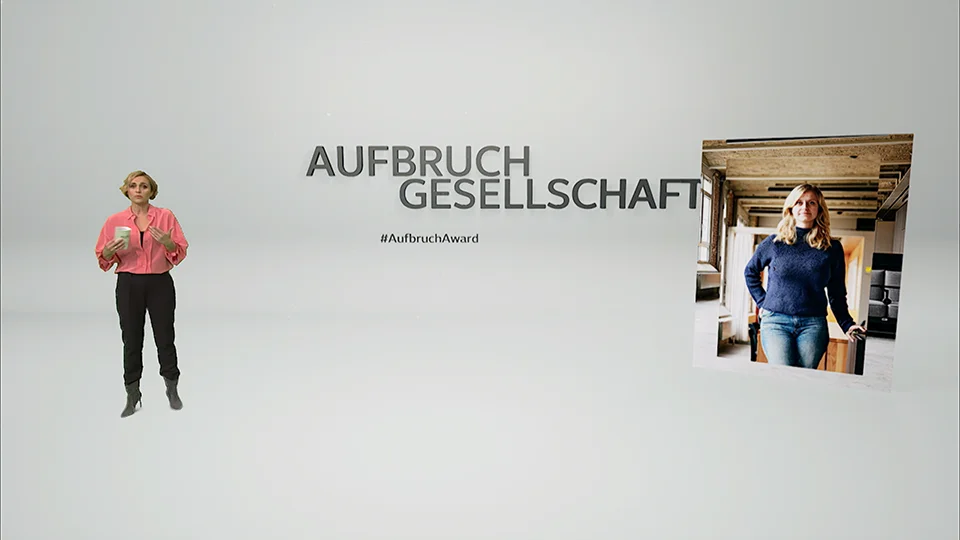

Die Preisträgerin im Bereich Gesellschaft, wird in einer urbanen Miniaturlandschaft ihrer Berliner Arbeitswelt integriert.

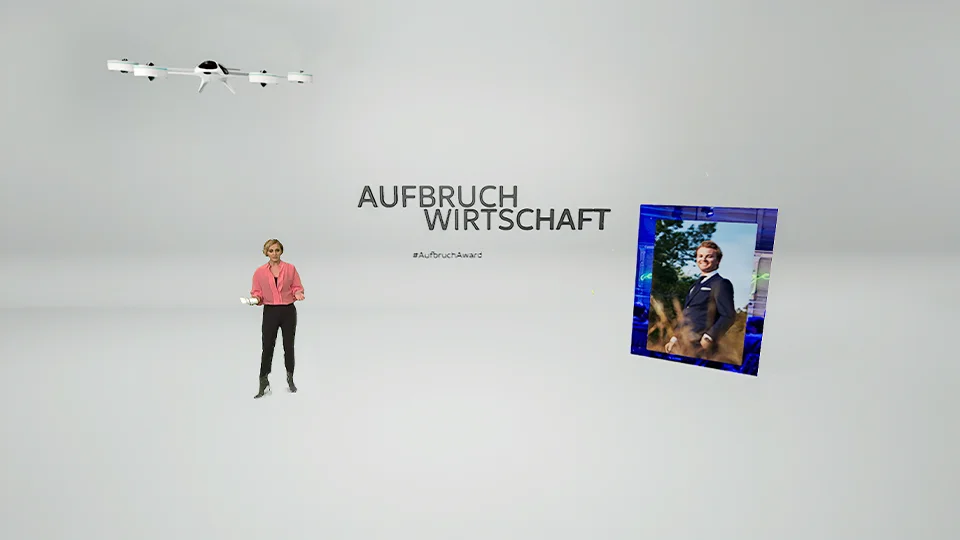

Ein futuristischer Quadcopter fliegt das Panel für Filminhalte heran, während Caren Miosga Nico Rosberg zu seinem Projekt befragt.

Konzept

Ehrlich und kurzweilig muss es sein. Dafür bedarf es einiges an Technik und Nerdigkeit.

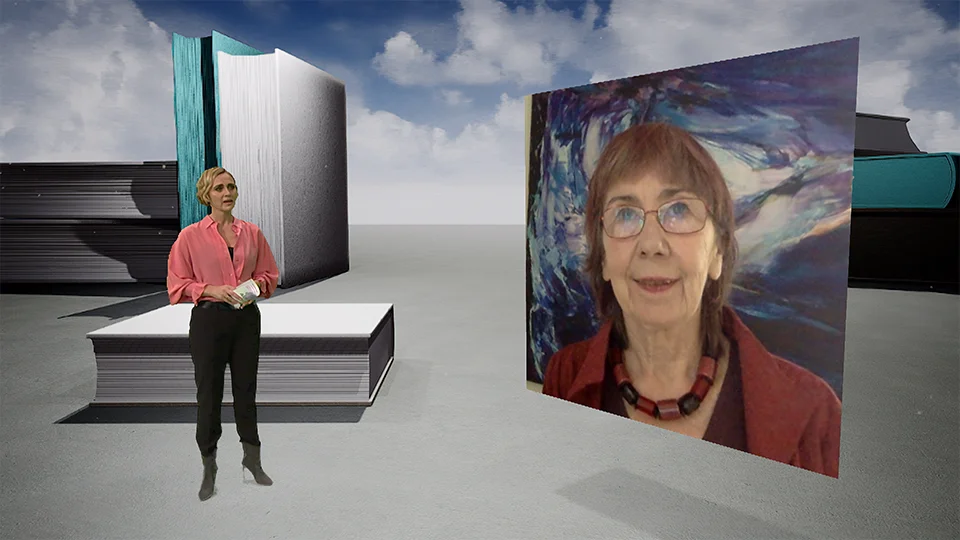

Um nun dem Zuschauer vor dem eigenen Display zuhause oder unterwegs ein spannendes Ereignis zu schaffen, entwickelten wir gemeinsam mit den Kollegen von StudioNOW eine variantenreiche Show-Dramaturgie. Je nach Programmpunkt konstruierten wir eine individuelle Szenerie in Form einer virtuellen 3D Welt. Die drei Preisträger sollten jeweils in einer signifikanten XR-Umgebung inszeniert werden. Diese wurden dann aus entsprechenden Elementen, die in direktem Zusammenhang mit ihren Projekten und Wirkungsbereichen stehen konzipiert und in einer 3D Umgebung gebaut.

Die Moderation sollte ein neutrales, undefiniertes und puristisches XR-Environment bekommen. Lediglich animierte 3D Objekte hatten die Funktion an den dramaturgisch entsprechenden Stellen in die folgende Welt hinüberzuleiten.

Die Einblendungen von Video-Livebild und vorproduzierten 16:9 Film-Einspieler war überstehende Flächen, die vollständig in die Landschaft integriert waren, zu jedem Zeitpunkt möglich. Zugleich konnten auch einige virtuelle Medienflächen in jeder XR-Welt beispielsweise von futuristischen Fluggeräten hereingeflogen werden, wie zur Laudatio für das Sieger-Projekt von Nico Rosberg in der Kategorie Wirtschaft.

Die virtuellen Kameras sorgten dafür, dass die Perspektiven aus jeder XR-Umgebung szenenübergreifend ein abwechslungsreiches Streaming-Bild ergaben und der Zuschauer immer wieder neue kleine Details über die Sendung hinweg entdecken konnte.

Umsetzung

Perspektivwechsel in eine andere Welt

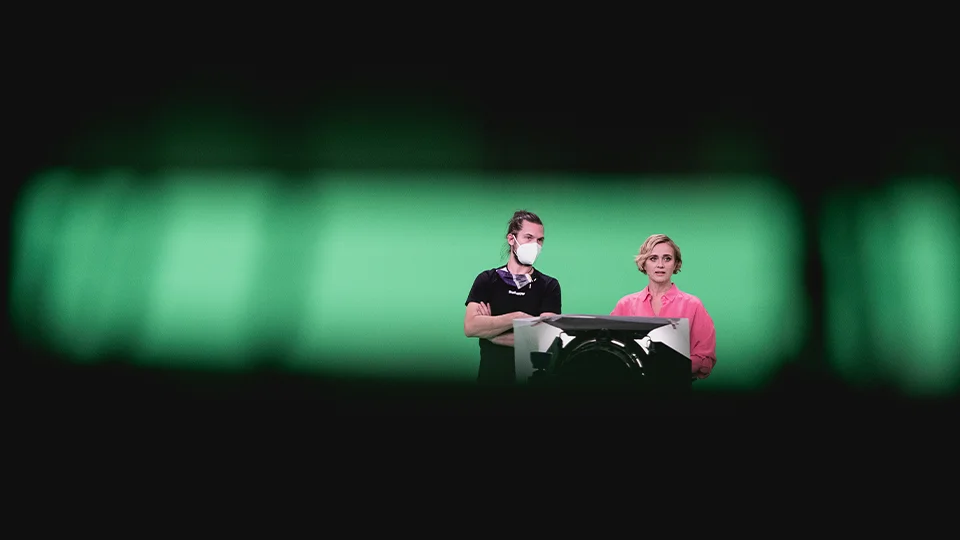

Im Rahmen der Produktion wurde uns ein Greenscreen Studio vorgegeben. Zwei bewegliche Kameras – ein Kran mit einem 5m Ausleger und eine Studio Kamera – waren für die Einstellungen vorgesehen.

Das Kamera-Tracking erfolgte via RedEye und wurde über das Stype Protokoll weiterverarbeitet.

Für das Real-Time Rendering der XR-Environments sollte Epic‘s Unreal Engine 4.26 zu Einsatz kommen. Die von uns darin vorgefertigten Maps wurden auf einer Disguise RX2 Maschine gerendert und ausgegeben. Die Video Plates wurden via Notch und Unreal in Kombination integriert und animiert. Die technische Umsetzung geschah in enger Zusammenarbeit mit dem Technikdienstleister AMBION.

Komplexität

Gemeinsam lernen wir zu sehen. Das Auge sieht nichts, die Kamera dafür umso mehr.

Das Greenscreen Studio als Drehort für eine virtual Production hat einige Nachteile gegenüber einer LED- Cave. Die Beleuchtung muss für den automatischen Realtime-Key immer gleich sein. Das bedeutet, die Protagonisten stehen im immer gleichen Licht-Setup. Das bedeutet, das auch in allen XR-Environments immer die gleiche Tageszeit/Lichtstimmung vorherrscht.

Das Kamerateam muss geübt sein im Umgang mit Umgebungen, die nicht sichtbar sind. Sie müssen sich in Vorfeld genau in der jeweiligen Szenerie auskennen, um die Orientierung zu behalten. Dies bedarf einiges an Probenzeit, die mit kalkuliert werden muss. Denn genauso brauchen die Darsteller, in unserem Fall die Moderatorin, Zeit sich in der virtuellen Welt zurecht zu finden. Schnell steht man ungewollt vor oder hinter einem virtuellen 3D Objekt, das man eben im realen Umfeld nicht sieht und nimmt somit die Illusion der sich verschmelzenden Realitäten im Livebild für den Stream. Die Positionierungen von Grafiken und Bildinhalten wird im Vorfeld auf Vordergrund und Hintergrund definiert.

Eine weiter Hürde sind Latenzen in der Weitergabe von Daten wie z.B. dem realen Kamerabild und den virtuellen Real-time Inhalten. Diese Latenzen müssen gemessen und im Vorfeld austariert werden. Darüber hinaus ist eine gesicherte, konstante Framerate des Real-time Contents absolut wichtig. Sie muss konstant über der Sendeframerate liegen, da sonst im schlechtesten Fall Kamerabewegungen nicht in Echtzeit mit gerendert werden können und das Bild z.B. stottert.

Abhängig von der Performance der GPUs der Rudermaschinen, muss im Vorfeld der Live-Produktion auch der „Level of Detail“ in den Szenerien definiert sein. Viele Effekte überfordern die GPU.

Effekt

Am Ende waren alle gemeinsam unterwegs.

Dieses Projekt hat uns viele Aspekte und Möglichkeiten nähergebracht, inwiefern sich eine Veranstaltung, die für gewöhnlich mit vielen Menschen auf einer Bühne stattfindet, in ein Format gebracht werden kann, bei dem alle Protagonisten an unterschiedlichen Orten vor dem eigenen Video-Telefon sitzen. Am Ende ist eine Inszenierung wichtig, die den Zuschauer mit auf eine Reise nimmt, die Hauptdarsteller darin einbindet und trotzdem die wesentlichen Inhalte klar transportiert eine gelungene und kurzweilige Online-Show geworden.

Client Google & Süddeutsche Zeitung

Agency Studio Now GmbH Berlin

XR Content DNM

CREATVIE DIRECTION Robin Kornemann

Art Direction Realtime Baptiste Stecher

Realtime Artists

Baptiste Stecher &

Niklas Giesen

Technical Service Provider Ambion GmbH

Project Management Andrea Wichmann